阿西莫夫机器人三定律或已过时?伯克利教授定义AI发展“新三原则”

AI能给我们的生活带来便利,但也会造成意想不到的“惊喜”。

试想2046年的某一天,你去机场赶飞机时间来不及了。于是,你对自动驾驶的网约车说:“请送我到旧金山机场,越快越好!”于是,自动驾驶汽车以以200英里/小时的速度冲向机场,闯了无数红灯,还撞倒了几辆自行车。

而你,一到机场,就被开着直升机赶来的警察拷走了。

这个例子说明,当人工智能片面地理解人类的需求时,可能制造出新的麻烦。

而这只是众多AI的潜在“作恶”可能的一种。在硅谷,顶尖大学的学者们一致认为,AI在给未来带来无限可能的同时,也可能带来各种安全隐患。

那么,我们应该如何去确保AI不作恶,“以人为本”地发展呢?来自加州大学伯克利分校的斯图尔特·罗素(Stuart Russell)教授在一次最新的演讲中给出了他的答案。

斯图尔特·罗素(Stuart Russell)是加州大学伯克利分校的电子工程和计算机科学教授,他的书《人工智能:现代方法》(与谷歌研发总监彼得·诺维格合著)是人工智能领域的标准书;它已被翻译成13种语言,并在118个国家的1,300多所大学中使用。

(Stuart Russell教授,图片来自网络 )

人工智能发展的目标已有偏差

近年来,研究者们普遍认为,AI是理性的,它能够通过感知周围的环境,来最大化实现它的目标。研究者往往将发展AI的目标设定为人类级别(human-level),或是超人类(superhuman)级别。但Russell教授认为,如果我们真的按照这个目标去发展AI,可能会引发很多潜在的问题。

就像文章开篇的例子一样,Russell教授认为,如果我们按照纯理性目标构建人工智能,将会麻烦重重。他在演讲中举了另一个例子:“当你要求AI帮你取咖啡,其实你不是希望它要不惜一切代价,比如清空我的银行账户,或者是在沙漠上跋涉300英里来帮你完成取咖啡的目标 。但是,AI可能并不这么认为。”

这是什么原因呢?过去,人们假设机器人对目标具有完备的知识。而实际上,AI对目标往往仅具有不完善的知识或只拥有部分知识。因此,由于对整个人工智能定义的目标偏差,人们往往不知道我们对AI的指令将会带来什么样的后果。这种未知,使很多人对人工智能产生了各种负面或悲观的预测。

因此,Russell教授认为,当前AI发展最关键的问题,是需要调整AI研究的重点方向,以便将来我们不会面临这种风险。

“新三原则”,创建以人为本 的AI

“在传统的模型里,人类被假定是足够聪明的,他们往往能够通过行为来实现自己的目标,而机器也能够达到足够聪明的程度,使他们自己能实现他们的目标。但是,人类并不想创造出比我们更聪明的物种。我们想创造的AI应该是对人类有益的,他们的行为能够达成我们人类而不是机器自己的目标。”

针对这一点,Russell教授提出了三个新原则,重新将人工智能定义为“可证明对人类有益的人工智能”(ProvablyBeneficial AI)。

第一原则:利他主义(Altruism)。这个原则意味着,机器的唯一目标是最大化地实现人类的目标与价值。

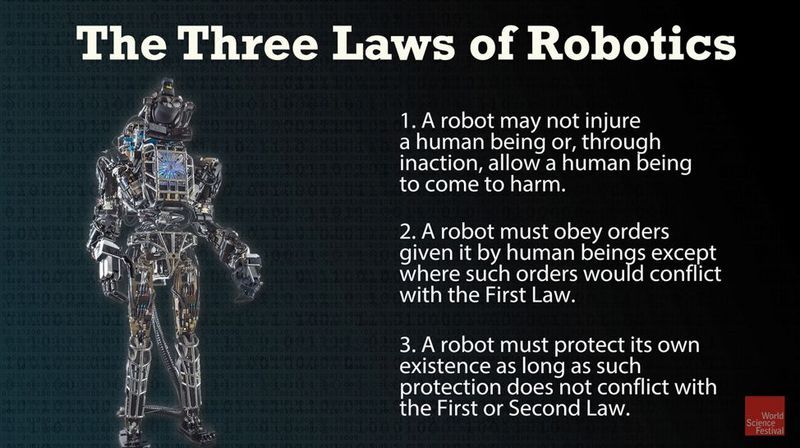

这一点与1942年艾萨克·阿西莫夫所定义的机器人三定律背道而驰。在阿西莫夫的定义里,机器人在不伤害人类,但要在遵从人类要求的基础上保护自己。“他的第三条原则指出,机器人一定要维护自己的生存。 但我定义的机器对维护自身生存毫无兴趣。”Russell教授说。

( 阿西莫夫的机器人三定律,图片来自网络,版权属于原作者)

第二原则:谦逊原则(humility) ——AI对人类应该保持敬畏之心。

在这一原则的指导下,AI要承认自己并不是无所不知和无所不能。这也就是说,机器需要知道将人类的价值最大化,但它也要清楚自己并不能完全理解价值的含义。

因此为了对人类有用, 它就得通过观察人类做的选择,根据人类给予它的信息去学习、掌握人类的需求。

机器需要承认,人类才是需求的主宰。而这一原则,对于我们未来制造出安全的人工智能十分重要。

第三原则:基于人类的行为给机器设定偏好提供依据。

设置这一条原则的原因是,机器往往无法准确了解如何实现人类的价值。但是没关系,人类可以辅助机器来实现。因此要增加人和机器的互动环节。

Russell教授认为,机器人设计的目的并不是只为了满足一个人或者一个用户的愿望, 而是去尊重人们都认可的道德价值观。“比如,人类可能会做错事,产生违背道德准则的行为。但我们并不希望机器人复制这些行为。反之, 我们希望机器人去尝试理解人类做事的动机和人类共通的道德观, 而且在合适的情况下制止人类去做那些不该做的事。”

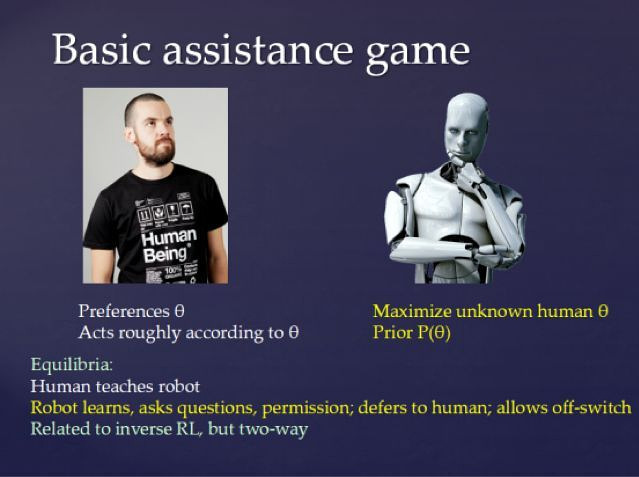

为了更好的解释这三条原则,Russell教授提出了辅助游戏(assistance game)的方法,即增加人类与AI的互动过程:这个辅助游戏模型假设人类有自己的偏好,并会根据这个偏好去行动;在AI的系统里,人类的偏好被作为先决条件引入,机器人虽然不知道环境中什么其他的条件值会影响人类的偏好,但它需要知道它的最终的目的是尽可能地寻找满足人类的偏好的最优解。

因此,它需要使用主动学习(active learning)的方式掌握更多的信息,同时得到人类的反馈,以了解人类的偏好,并将最终的决策权交给人类。

Russell教授举了一个图形分类领域的例子。在旧的AI模型下,人们只是给图像分类定义了一个简单的数学目标,即通过数学方法尽可能地将预测偏差减到最小。但这个数学目标却并没有考虑种族价值观的取向,“而这个过于“理性”的算法使Google Photos功能里的图像分类算法错误地将黑人分类成大猩猩,结果导致了几百万美元的公关损失。”

( Google Photos,图片来自网络,版权属于原作者)

用新的模型来应用到这个情景里,人类会给予AI一些安全的图片进行分类,同时AI会像人类询问在分类时应该考虑的其他因素都有什么,于是人类会教给他们种族、语言等差异或尊重、同理心等美德,来帮助AI避免错误的分类。

(教授的PPT,图片来自其官网)

新AI原则可能面临的挑战

这个新的模型意味着整个AI的研究方向可能会被改变。但是Russell教授对这个模型持有乐观的态度。

在Russell教授10月份刚发行的新书HumanCompatible: Artificial Intelligence and the Problem of Control中,解释了这个新模型的必要性。新书解释了AI的工作原理,并认为它具有巨大的能力来改善我们的生活,但同时也强调,人类必须确保永远不会失去对功能强大的机器的控制。

目前模型的主要问题在于,它不太善于学习我们的偏好。而要让机器学习人类偏好需要大量的投入和研究,将耗费巨大的金钱和精力。

但是,Russell教授认为这是必要的。如何通过重塑AI的基础来避免机器对人类产生严重的威胁,确保机器的发展遵循人类的目标,而不是机器的目标,将是AI新发展模式需要研究的重点。

(AI助手,图片来自网络)

但是,调整AI的研究方向意味着将会面对很多挑战。

第一个挑战在于机器如何将人类的行为语言与人类偏好联系起来。“比如,我们在说某句话的时候有时并不真的意味着我们想要这句话字面上的意思。”教授解释道。“这就需要培养机器在不同语言环境下对人类语言和行为更深的理解能力。”

第二个挑战是人类有时也无法准确认识自身偏好。例如,我们的经历性自我(experiencing self)和记忆性自我(remembering self)可能具有不同的偏好,如果是这样,那么AI应该针对哪个进行优化?

此外,人类的偏好通常会随着时间而变化:AI是否应该针对我们当前的偏好进行优化,即使它知道将来将会发生可预测的变化?

最后,还有一个挑战在于,机器怎样去了解人类所共通的偏好,比如利他主义、骄傲、竞争、羡慕等等,并且兼顾人类之间(比如不同的社会、文化、种族结构)偏好的不同呢?教授认为这些是更深远而长久的问题。

面对这些挑战,研究者们该如何应对呢?教授认为,我们首先需要研究的一个重点在于“如何确定人类的偏好是什么”。

在书里,Russell教授提出了一个关于人类偏好模型的初步构想。他认为我们可以设置一个可扩展的分层先验(expandablehierarchical prior),其中最初存在相对简单的假设,但是随着假设在解释数据时变得更糟,我们将“扩展”假设集来寻找对数据更合理的解释。 但同时,教授也认为这样做可能在计算上的要求更高,同时也并不能处理人类偏好在时间上的变化。

(教授的新书,图片来自网络)

此外,教授认为还应继续对理论的探索,尤其强调跨学科合作,例如计算机科学、经济学、认知科学等领域深入的交叉合作。

同时,实践与应用层面的工作也要跟进,比如在自动驾驶、AI助手中去探索应用,通过结合心理学与认知科学,进一步了解人类认知的构造,最终与哲学、社会学、政治科学等领域的学者合作,探索人工智能在宏观层面的长期目标。

你对教授提出的人工智能领域的新目标是否认同呢?你认为我们应该怎么做才能实现更好的人工智能?欢迎在下方评论!