AI骗走173万:伪造老板声音要求转账,赃款几经易手,骗子无影无踪

“来我办公室一趟。”

“您哪位啊?”

“啥?你听不出来我是谁吗?”

“是……张总吗?”

接着,就会发现电话那头的“张总”,让你去找财务部的同事,然后以“陪客户”、“联络高层”的由头,要求给一个陌生账号汇款……

你也接到过类似的电话吧?这个诈骗套路关键的一环就在于,你要把他的声音听成自己公司某个老板的声音。

好在,大部分人不会听错,因此也不会上当受骗。

但现在,借助AI语音合成技术,骗子可以让他的声音和你老板一模一样,并且一家英国公司真的上当受骗了,被骗走了22万欧元(173万人民币)巨款。

案发过程

据《华尔街日报》报道,总部位于巴黎的保险公司裕利安宜(Euler Hermes)的一家客户上当了。

这家客户是总部位于英国的一家能源公司,该公司的母公司位于德国,英国的是子公司。

一天,英国子公司CEO接了母公司“老板”电话,毕竟母公司是德国的,因此母公司老板日常说英文的时候会有德国腔。英国子公司CEO一听,来电人的英语带点德国口音,跟母公司的老板一毛一样,那就是老板本人了。

原来,德国“老板”在跟“匈牙利供应商”谈生意,账要从英国的子公司走,也就是英国子公司把钱打给“匈牙利供应商”,德国的母公司后续再给英国子公司补上。

德国“老板”要求的时间紧任务重,必须在一个小时之内给“匈牙利供应商”的账户打22万欧元,折合人民币173万元。

钱打过去之后,在当天稍晚的时候,“老板”又打电话来了。这次“老板”说,刚才那22万欧元,德国的母公司已经给英国子公司转过去了,现在需要英国子公司再转一笔钱。

这下英国子公司的人就觉得不对劲了。一方面,“老板”转的钱没到账;另一方面,怎么“老板”这次是从奥地利打过来的电话呢?

虽然英国子公司没有第二次上当受骗,但之前打的22万欧元已经回不来了。调查人员发现,这22万欧元打到“匈牙利供应商”的匈牙利账户之后,被转到了墨西哥,之后转到了其他地方,因此警察也找不到骗子在哪儿。

裕利安宜保险公司要给客户保密,没有透露这是哪家公司,最后他们按照英国子公司的要求给予了理赔。

语音克隆技术相当成熟

这家受骗公司遭遇的核心问题,在于打来的电话实在太像母公司那个真正的老板了。

骗子本人是不太可能刚好是这个声音的,而能让老板的声音出现,并且说出特定的话,用到的是语音克隆或者语音合成技术。

语音克隆技术已经有了许多应用,比如此前,搜狗输入法就在终端推出了“变声”功能,你对着手机说一句话,发送给好友之后就是林志玲、周星驰、高晓松等明星的声音。

在今年的科大讯飞新品发布会上,就现场播报了合成的罗永浩和林志玲的声音。

语音合成就更成熟了,你常用的百度地图、高德地图里,导航用的林志玲、易烊千玺等明星的语音包,都是用明星本人说的话做语料库训练,通过语音合成技术生成的。

甚至,今年315晚会上的AI打骚扰电话,打来电话的声音也是语音合成的。

如果你想体验一下语音克隆的效果,可以试试最近在GitHub上非常火的这个实时语音克隆的开源项目:

Real-Time-Voice-Cloninghttps://github.com/CorentinJ/Real-Time-Voice-Cloning

项目中已经给出了预训练模型,下载到本地部署后,每次只要5秒钟,就可以把另外一个人说的话,变成你的声音。

也是因此,语音类的技术易得、易用,效果也不错,被坏人盯上也是难免的。

声音造假,开视频验证呢?

以前的电信诈骗都是短信、微信文字,上当者会被银行工作人员提醒:打个电话确认一下。

现在,恐怕不仅要打电话,还要视频一下,以确保是本人了。然而,现在的一些AI技术,不仅可以合成特定人的语音,甚至还能根据语音对口型、处理视频。

可以让人物的静态照片动起来,并且说出特定的话。帝国理工学院和三星这篇《Realistic Speech-Driven Facial Animation with GANs》论文,就用不少明星静态照片:

还可以把录好的视频改掉。斯坦福和普林斯顿的这篇《Text-based Editing of Talking-head Video》论文中,录好的说话视频,可以把声音、口型全部改掉:

苹果今日收盘价191块4,改成182块2你也看不出来。

也可以让照片中的人物边说话边配上丰富的表情姿态。来自三星和俄罗斯斯科尔科沃科学技术研究所的这篇名为《Few-Shot Adversarial Learning of Realistic Neural Talking Head Models》的论文中发表的技术,就让静态的蒙娜丽莎:

变得活灵活现:

要知道,类似的AI技术有不少都是开源的,如果被用在恶意用途上,被用来混淆视听、诈骗,将造成极大的恶果。

实在不行,用AI来抓AI骗子

不管是处理语音、图片还是视频,这些技术开发出的新功能一般都被认为能在帮助人类节省时间、提升乐趣等方面起到作用。

但是,拿来作恶的也不少。可能让人名誉扫地的AI换脸应用、可能侵犯隐私的人脸识别、加上如今的AI诈骗,技术总有其两面性。

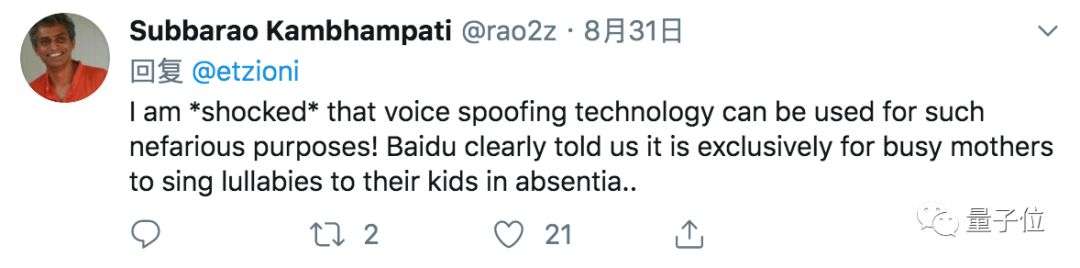

正如AAAI前主席Subbarao Kambhampati看到这则消息之后的评论:

我很震惊语音技术会被用于这种邪恶的目的!百度不是明确的告诉过我们,语音技术是用来让忙碌的妈妈给娃唱摇篮曲的嘛?

也有人提出,以AI制AI可能是个不错的方法:

我们需要人工智能辅助网络安全框架来解决人工智能驱动的网络犯罪问题

最后,要是你接到了听起来和老板声音一样的电话,会用什么方法去辨别呢?

参考链接:https://www.wsj.com/articles/fraudsters-use-ai-to-mimic-ceos-voice-in-unusual-cybercrime-case-11567157402